von Lucas O. Seastrom

Heutzutage denken wir bei digitalen visuellen Effekten oft an lall die egendären Figuren, die mit Computergrafik-Tools zum Leben erweckt wurden. Diese Effekte waren von Anfang an ein Kernelement jener Innovationen, die bei Industrial Light & Magic (ILM) entwickelt wurden und Figuren wie den Buntglasritter in Das Geheimnis des verborgenen Tempels (1985), den Pseudopod in Abyss (1989), den T-1000 in Terminator 2 – Tag der Abrechnung (1991) und natürlich die Dinosaurier in Jurassic Park (1993) hervorbrachten

Nach Jurassic Park nahmen bei ILM Projekte mit digitalen visuellen Effekten zu, die jeweils neue Durchbrüche auf dem Gebiet der Software und Technik erforderten, um bestimmte Ziele zu erreichen. Als Regisseur Rob Cohen Dragonheart (1996) ins Unternehmen brachte, wusste das ILM-Team, dass dies eine besondere Herausforderung mit nachhaltigen Auswirkungen werden würde. Es war das erste Mal, dass eine realistisch aussehende, nicht-cartoonartige CG-Figur eine Hauptrolle in einem großen Kinofilm spielen würde, und es war noch dazu die erste, die von einem großen Hollywoodstar gesprochen wurde.

Das Fantasy-Abenteuer Dragonheart erzählt die Geschichte eines heruntergekommenen Ritters (gespielt von Dennis Quaid), der eine ungewöhnliche Partnerschaft mit einem streitsüchtigen Drachen namens Draco (gesprochen von Sean Connery) eingeht. Für den Film war eine vollständig computergenerierte Kreatur erforderlich, die mit der Tiefe und Emotionalität einer dramatischen Hauptfigur sprechen konnte. Die erforderlichen Details und Nuancen in Dracos Darstellung stellten dabei die zentrale Herausforderung dar.

„James Straus war damals der Animationsleiter und Scott Squires der Hauptverantwortliche für die visuellen Effekte“, erklärt uns Rob Coleman, der als Animator an Dragonheart mitwirkte und heute als Kreativdirektor des ILM-Studios in Sydney arbeitet. „Sie nahmen den T-Rex-Kopf aus Jurassic Park und versahen ihn mit einer ganzen Reihe von Formen, wie einem Lächeln, einer hochgezogenen Lippe und Phonemen für A-E-I-O-U. Mit dieser Grundlage animierte James einen Proof-of-Concept für Rob Cohen, und so erhielt ILM dann den Auftra. Das Ganze war aber so zeitaufwendig, dass wir den Film mit den vorhandenen Tools nie hätten fertigstellen können. Deshalb brauchten wir ein neues internes Gesichtssystem.“

Cary Phillips, heute einer der Forschungs- und Entwicklungsleiter von ILM, war 1994 gerade erst als Software-Ingenieur eingestellt worden. Während seines Ingenieurstudiums an der Universität von Pennsylvania begeisterte er sich für Computergrafik und zog nach Kalifornien, um bei Pacific Data Images zu arbeiten, bevor er zu ILM kam. Phillips wurde schon bald gebeten, bei Dragonheart mitzuhelfen.

Zu dieser Zeit war ILM mit der Figurenanimation für Universal Studios Casper (1995) beschäftigt, und zwar mit Werkzeugen, die in Sachen Gesichtssystem ziemlich „primitiv und archaisch“ waren, wie Phillips anmerkt. Animatoren mussten einzelne Textdateien manuell eingeben, um bestimmte Gesichtsformen in eine bestimmte Einstellung zu laden. Diese Textbefehle wiesen die Software an, wie die Figur im Laufe einer bestimmten Einstellung zu positionieren war.

„Die Computeranimation funktioniete im Wesentlichen wie Stop-Motion-Animation“, berichtet Phillips, „und es gab einfach keine Möglichkeit, Dragonheart so zu machen, wie wir Casper gemacht hatten. [Der Leiter der Vorproduktion] Alex Seiden zeigte mir ein Modell, wie seiner Meinung nach die Benutzeroberfläche eines Gesichtsanimationssystems aussehen sollte“, so Phillips weiter.

„Es gab da ein Fenster mit einem Gesicht und ein weiteres Fenster mit verschiedenen Gesichtsausdrücken, und jedes hatte einen Schieberegler mit einer Zeitachse. Ich schaute es mir an und verstand fast sofort, was nötig war.“

Zu dieser Zeit war Softimage die führende Anwendung für CG-Animationen, das erste System seiner Art, das „animator-gesteuert und interaktiv“ war, so Phillips. „Es war leistungsstark, aber langsam, bzw. es war nur schnell, wenn die Modelle sehr einfach waren. Es basierte alles auf Drahtgittermodellen. Man konnte nie ein schattiertes Modell sehen. Es hatte auch keine Plug-in-Schnittstelle, im Gegensatz zur heutigen Funktionsweise. Man konnte es in keiner Weise erweitern.“

Phillips hielt es nicht für möglich, Dracos Gesichtsausdrücke mit Softimage zu animieren. So entwickelte er stattdessen selbst ein neues Tool.

Dessen Arbeitsablauf war relativ einfach: Animatoren erstellten die Körperbewegungen der Figur in Softimage, wie sie es zuvor schon mit einer herkömmlichen Drahtgitteransicht getan hatten. Dann speicherten sie die Datei und öffneten sie in einem neuen Programm, das Phillips Caricature nannte und das nur das Gesicht der Figur mit einer sichtbaren Hautoberfläche darstellte.

„Es war, als würde man eine Maske für die Figur animieren“, so Phillips. „Es war ein speziell entwickeltes Programm. Es zeigte einem das Gesicht und ließ einen damit interagieren.“

Das Ergebnis war ein Wendepunkt für die Animatoren von ILM, die das Programm kurz Cari nannten, als doppelte Anspielung auf seinen Namen und seinen Schöpfer (was Phillips ursprünglich eigentlich gar nicht beabsichtigt hatte).

„Der Kopf von Draco hatte die gleiche Anzahl von Punkten in seiner Topologie wie der gesamte T-Rex drei Jahre zuvor“, so Rob Coleman. „Um diese Art von Daten zu bewegen, musste man normalerweise eine Form bewegen und 30 Sekunden warten, bis der Computer alles neu berechnet hatte. Dann wurde es aktualisiert und man schaute es sich an und vielleicht hatte man es zu weit oder nicht weit genug bewegt, sodass man es erneut bewegen musste. Man animierte also zeilenweise, und es war schrecklich. Als Cari ins Spiel kam, hatten wir plötzlich digitale Schieberegler in Echtzeit. Man konnte von einem neutralen Gesicht zu einem glücklichen oder traurigen Gesicht wechseln, oder ich konnte einfach ein Auge blinzeln oder eine Wange aufblähen lassen oder auch ein Grinsen animieren. Wir hatten jede Menge Vorlagen.“

Coleman betont weiter: „Das war bahnbrechend, denn plötzlich konnte man den Rest des Drachen ausschalten, nur das Gesicht auf dem Bildschirm sehen und alle seine Gesichtsausdrücke gestalten Einer der Einstellungen, an der ich arbeitete, zeigte Draco, der sagte: I am the last, ich bin der Letzte! Man konnte Sean Connerys Stimme und Akzent hören, wie er lasht sagte, und ich schaute in den Spiegel, um die richtige Mundform zu finden. Dann legte ich ein Keyframe für die Animation fest, schaute es mir an und änderte es. So waren wir in der Lage, mehr Iterationen pro Tag und pro Woche durchzuführen, was unsere Arbeit so viel besser machte als zuvor.“

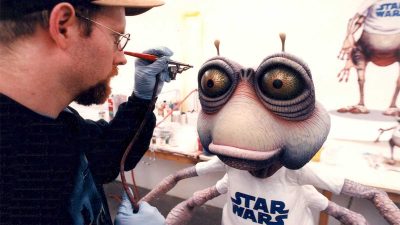

Im Laufe der Arbeit wurde Phillips zu einem echten Teammitglied der ILM-Künstler, um ihr Feedback abzuholen. Zu diesen Künstlern gehörte auch der CG-Modellierer Paul Giacoppo, ein weiterer Neuzugang, der sich einem Team von vier Personen anschloss, das für die Gestaltung von Dracos Körper und die Erstellung der wichtigsten Ausdrucksformen verantwortlich war, welche die Animatoren dann darstellen konnten.

„Ich hatte Unmengen von Bildern von Sean Connery und wir wollten seine Persönlichkeit in die Figur einfließen lassen“, erzählt Giacoppo. „Eine der Herausforderungen war die Ausdruckskraft von Connerys Augenbrauen. Er kann sehr streng aussehen, aber auch sehr ausdrucksstark und emotional. Man kann sehen, wie sich seine Augenbrauen bewegen und wie er auf charmante Weise mit dem Mundwinkel spricht. Cari erlaubte es uns, eine Form zu erstellen, die den Mund lächeln lässt, und dann konnte man sie zur einen oder anderen Seite schieben.“

Das Ergebnis war etwas völlig Neues, das ILM so noch nie zuvor erreicht hatte. Coleman erklärt: „ILM hatte den T-1000 geschaffen, was bemerkenswert war, aber ich glaube, er sagt in seiner Flüssigmetall-Form nur einen einzigen Satz, wenn er im Hubschrauber sitzt: Raus hier!

Das ist beeindruckend und technisch erstaunlich, ebenso wie die Wasserschlange in Abyss, aber diese Figuren mussten nicht wirklich schauspielern. Eine digitale Figur mit Emotionen und schauspielerischen Fähigkeiten zu entwickeln, die sich die Leinwand mit Schauspielern wie Julie Christie und Dennis Quaid teilen kann, war eine enorme Herausforderung. ILM war, wie immer, dazu bereit, aber als Animatoren waren wir noch nie auf diese Weise auf die Probe gestellt worden. Man hatte uns noch nie aufgefordert, die Aufmerksamkeit des Publikums zu fesseln und es glauben zu lassen, dass diese Stimme aus diesem Drachen kommt.“

Etwa ein Jahr nach dem Kinostart des Films zeigte Coleman George Lucas Szenen aus Dragonheart und anderen aktuellen Projekten. „Er stand da, als ich ihm zeigte, wozu Caricature imstande war“, so Coleman. „Ich erfuhr später, dass George bei diesem Treffen beschloss, dass ILM bereit war, die digitalen Figuren für Die dunkle Bedrohung zu stemmen. Er hatte darauf gewartet, dass die Technologie und Kunstfertigkeit von ILM einen bestimmten Punkt erreicht, weil er wusste, dass er einige Figuren mit Hilfe von Computergrafiken erstellen lassen wollte. Er wollte wie früher an Animatronik und Puppenspiel gebunden sein, sondern dass digitale Figuren mit realen Schauspielern auf eine Weise interagieren, wie es das in der klassischen Trilogie nie gegeben hatte.“

Bei nachfolgenden Projekten verlor das Team von ILM keine Zeit, bevor es die Leistungsfähigkeit seiner Werkzeuge weiter verbesserte. Schon bald konnten Animatoren den gesamten Körper einer Figur in Relation zu deren Gesicht sehen, das sie animierten. Neue „Cari Renders“ ermöglichten eine nahezu sofortige Wiedergabe von groben Animationen.

Nachdem ILM-Softwareentwickler Jim Hourihan ein neues Modellierungstool namens iSculpt entwickelt hatte, kombinierte er es mit Phillips zusammen mit Caricature, um ein System zu schaffen, welches es den ILM-Künstlern ermöglichte, sowohl ein Modell zu formen, als auch dessen Bewegungen einzustellen und beide im selben Programm zu animieren. Sie waren auch die Pioniere einer Technik namens „Model Correctives“, einem Tool in Caricature, mit dem Künstler Unvollkommenheiten in der 3D-Geometrie manuell beheben konnten, „wie mit 3D-Photoshop“, wie Giacoppo es ausdrückt.

ILM verfeinerte diese neuen Techniken bei Projekten wie Mars Attacks⁄ (1996), Vergessene Welt: Jurassic Park (1997), Men in Black (1997) und Flubber (1997). Jedes dieser Projekte stellte seinerseits ein Sprungbrett zu Die dunkle Bedrohung dar.

„Bei Episode I ging es wirklich darum, das, was wir hatten, auf ein Niveau zu bringen, das dem Umfang und der Größe des Films gerecht werden konnte“, so Phillips. „Vielleicht passte es in die Gesamtvision von George Lucas, weil er gesehen hatte, dass diese Dinge möglich waren. Aus unserer Sicht hatten wir diese Dinge zwar schon getan, aber nicht ansatzweise in dem Umfang, den er sich vorstellte. Das war schon erschreckend. Die Aufnahmen gewannen plötzlich eine neue Komplexität. Wir mussten die Werkzeuge dafür neu erfinden und neu implementieren.“

Neben Jar Jar Binks, Boss Nass, Watto und Sebulba spielten in Die dunkle Bedrohung eine ganze Reihe digitaler Co-Stars mit, ganz zu schweigen von den unzähligen digitalen Neben- und Hintergrundcharakteren. Jede der Innovationen von ILM im Bereich der visuellen Effekte stand im Dienst der Geschichte, die die Filmemacher erzählen wollten, und in Die dunkle Bedrohung hatten die digitalen Figuren ein erhebliches Gewicht. Ihre Glaubwürdigkeit und ihr Erfolg läuteten eine neue Ära des Filmemachens ein, deren originelle Figuren mit anderen Methoden nicht darstellbar gewesen wären.

Ein Großteil dieses Erfolgs ist der effektiven Zusammenarbeit zwischen Wissenschaftlern und Künstlern zu verdanken, und Phillips verkörpert diese so wesentliche Tugend. „Bis heute habe ich noch nie jemanden wie Cary getroffen”, meint Giacoppo. „Vor Dragonheart war ich es gewohnt, dass Leute einfach sagten: Hier ist das Programm und so funktioniert es. Aber Cary sagte: Probier dieses Programm aus und sag mir, wie es funktioniert.

Also gab ich ihm Feedback und er sagte Dinge wie: Ja, das ist nicht sehr schlau, oder? Ich glaube nicht, dass es intelligent funktioniert. Lass mich versuchen, es intelligenter zu machen. Er präsentierte seine Arbeit nach dem Motto: Zeig mir, wie es besser geht. Und er zeigte einem etwas Erstaunliches, etwas, das zu dieser Zeit sonst noch niemand getan hatte. Er hatte immer diese Energie und positive Einstellung. Er war so schlau, wenn es darum ging, Dinge auszuprobieren. Wir gaben ihm ein Problem und er kam mit einer kreativen Lösung zurück.“

Die Technik von Caricature wurde letztlich, in den 2000er Jahren, in das aktuelle Zeno-System von ILM integriert. Rückblickend nimmt die Software einen ungewöhnlichen Platz in der modernen Landschaft der visuellen Effekte ein, die immer komplexer wird.

„Caricature war ein System mit sehr klaren Eingaben und einem sehr klaren, begrenzten Zweck“, erklärt er es. „Die Dinge sind heute so viel komplizierter. Künstler haben ständig mit etwas zu kämpfen, das kaputt ist, und müssen Fehler beheben. Sie begeben sich auf Odysseen, um herauszufinden, warum etwas nicht richtig funktioniert. Caricature war einfacher. Es war zuverlässig, und wenn etwas schiefging, war klar, wie man es beheben konnte. Das ist etwas, woran ich mich gerne zurückerinnere.“

Die digitale Renaissance der 1990er Jahre bot fast einzigartige Chancen für diese Art von Durchbruch. „Es war eine goldene Ära für Innovationen in der Computergrafik, weil es eine Zeit war, in der die Fortschritte in der Hardware und der akademischen Forschung die verfügbaren Werkzeuge, insbesondere für Spielfilme, überholt hatten“, so Phillips abschließend. „Die Ausbeute war entsprechend gut. Es war eine Gelegenheit, die Möglichkeiten von Computern mit den Wünschen von Künstlern zu verbinden.“

1998 ehrte die Academy of Motion Pictures Arts and Sciences Cary Phillips mit einem Technical Achievement Award für das Design und die Entwicklung des ILM Caricature Animation System und würdigte damit seine Innovation und den bedeutenden und nachhaltigen Beitrag, den sie in der Geschichte des Films geleistet hatte.

0 Kommentare